Si vous gérez un SOC, concevez des détections ou prenez des décisions en matière de risques pour votre entreprise, cet article est écrit pour vous. Explique :

- pourquoi la façon dont nous interagissons avec les outils de sécurité est aussi importante que les outils eux-mêmes,

- comment l’IA change cette interaction,

- et à quels avantages pratiques vous pouvez vous attendre lorsque votre SOC commence à parler humainement.

Le SOC qui répond

Il est 3 heures du matin. Une notification apparaît dans votre espace de travail de sécurité. Ce n’est pas le type d’escalade qui fait monter l’adrénaline ; C’est un message complètement différent :

“Le rapport du matin est prêt. 2 847 événements ont été analysés pendant la nuit. Deux incidents nécessitent une attention particulière : une tentative de mouvement latéral dans le sous-réseau financier, une mauvaise configuration d’AWS exposant les données des clients. Contextualisés et classifiés. Le café d’abord ?”

Il ne s’agit pas d’un scénario de rêve, mais de l’aboutissement logique d’une transformation déjà en cours dans les centres d’opérations de sécurité : un SOC réactif.

Imaginez demander à votre SOC, non pas à un analyste de nuit, mais au SOC lui-même : « Quelles alertes sont les plus importantes aujourd’hui ? et obtenez une réponse concise et fondée sur des preuves en quelques secondes. Ce n’est pas une carte que vous devez décoder. Il ne s’agit pas d’une requête SIEM dont vous devez retenir la syntaxe. Juste une réponse humaine qui coupe le bruit et génère de l’action.

Les SOC d’aujourd’hui parlent encore comme des machines : des tableaux de bord remplis de widgets, des langages de requête qui nécessitent des spécialistes et des guides qui échouent lorsque la réalité s’écarte. Les SOC de demain parleront avec humanité et le feront sans sacrifier la profondeur au profit de la vitesse.

Pour comprendre pourquoi un SOC conversationnel est possible (et nécessaire), nous devons examiner ce qui fait actuellement obstacle à des décisions claires et rapides.

La barrière de la langue en cybersécurité

Les outils de sécurité ne parlent pas le même langage que le jugement humain. Les analystes passent leurs journées à traduire les règles SIEM, la télémétrie EDR, les consoles cloud, les flux de menaces et les systèmes de billetterie, chacun avec son propre modèle de données et sa propre syntaxe de requête. Cette surcharge cognitive transforme le jugement d’expert en API humaine.

La prochaine avancée ne sera pas davantage de télémétrie : ce sera un meilleur langage. Une couche conversationnelle unifiée permet aux agents d’IA d’interpréter diverses données, d’appliquer une logique de décision et d’expliquer les résultats en termes humains. Demandez : « Afficher les comptes privilégiés qui ont accédé aux données sensibles en dehors des heures de bureau la semaine dernière » et vous obtiendrez des résultats contextuels : des alertes corrélées, des informations pertinentes sur les menaces et un résumé concis de style analyste, et non des journaux bruts.

En réduisant les frais de traduction, les SOC conversationnels permettent aux utilisateurs de se concentrer sur ce qui compte : les intentions de l’adversaire, les risques commerciaux et les décisions difficiles.

Une fois admis que la traduction est une taxe cachée sur le temps des analystes, la prochaine faiblesse devient évidente : notre logique opérationnelle.

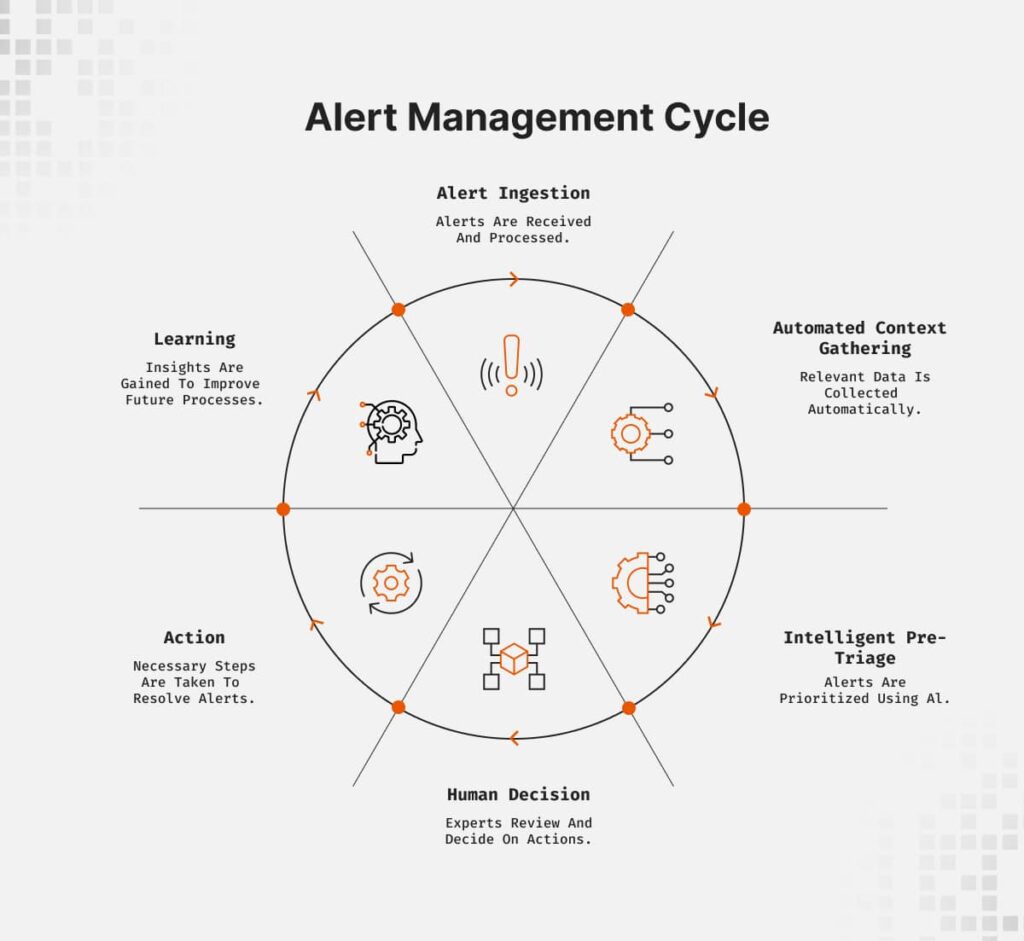

Des manuels aux boucles de raisonnement

Les manuels traditionnels sont par nature fragiles : ils supposent des conditions prévisibles et suivent des règles rigides. si x, alors y logique. Cela fonctionne pour les tâches de routine telles que la réinitialisation de mots de passe ou l’enrichissement d’IOC, mais échoue lorsque les attaquants improvisent ou lorsque le contexte change d’une manière que l’auteur n’avait jamais anticipée.

Les systèmes basés sur le raisonnement fonctionnent différemment. Ils ingèrent une alerte, rassemblent le contexte, corrèlent les sources, appliquent des renseignements sur les menaces et formulent des hypothèses. Au lieu de démarrer un flux de travail fixe, ils lancent une enquête dynamique : qui a déclenché l’alerte, qu’est-ce qu’ils ont fait d’autre, quelles preuves manquent et quelles conclusions étayent les données actuelles.

Ce n’est qu’alors qu’ils attirent un humain : “C’est ce que je sais, c’est ce que je pense, c’est là que je ne suis pas sûr : quelle est ta décision ?”

Il s’agit d’opérations continues et contextuelles : adaptatives, collaboratives et qui apprennent toujours des décisions humaines pour renforcer la prochaine enquête.

Les boucles de raisonnement nous offrent un processus interne plus riche, mais la valeur est multipliée lorsque ce raisonnement est exposé sous forme de conversation partagée. C’est là que ChatOps évolue de tâches planifiées vers une couche de collaboration en direct.

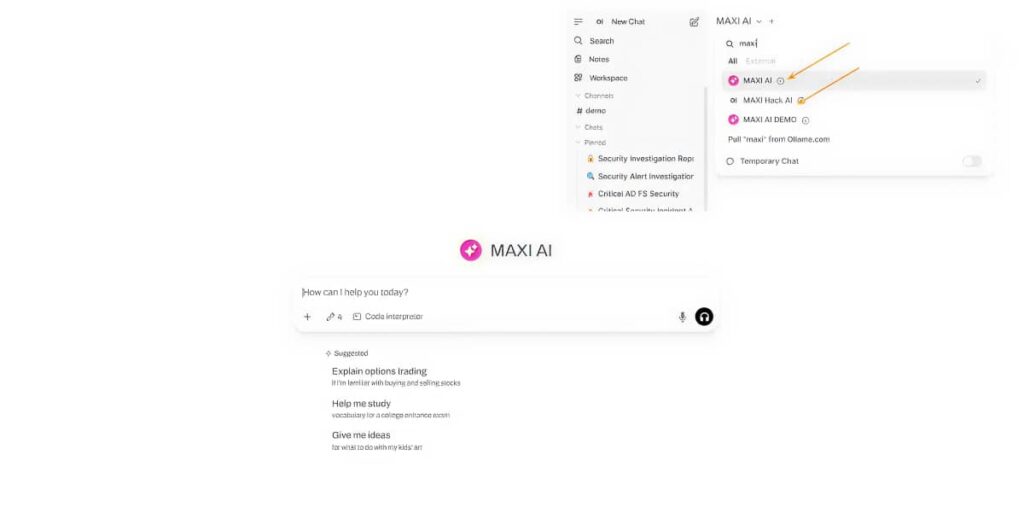

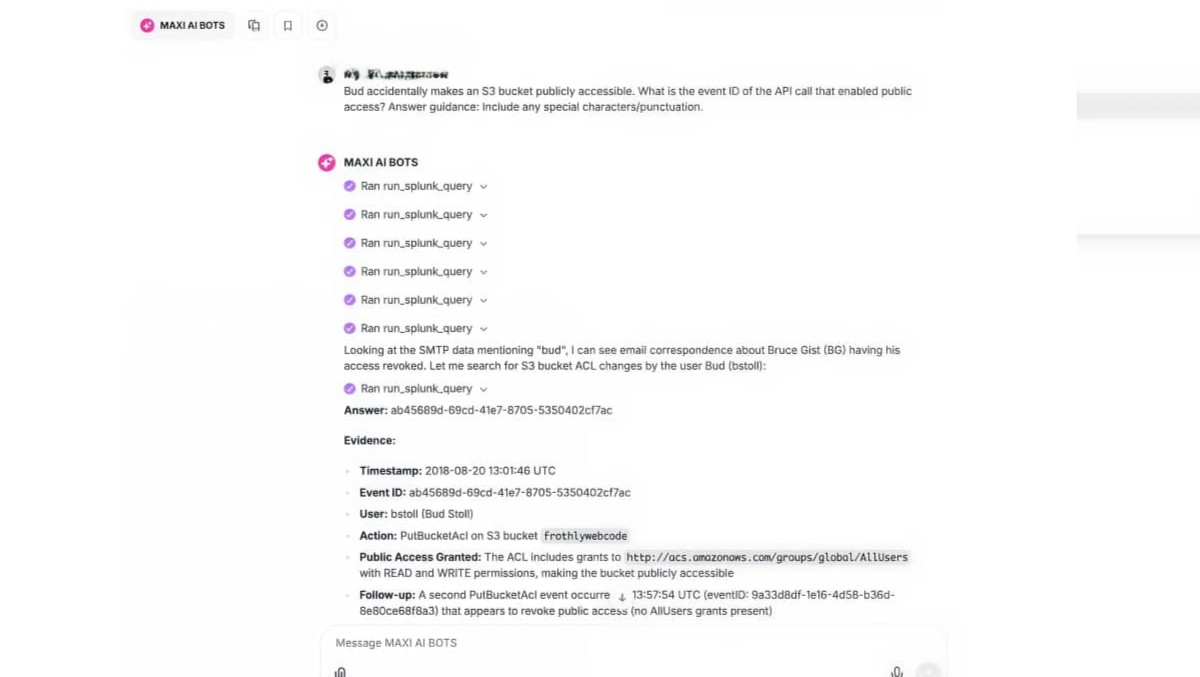

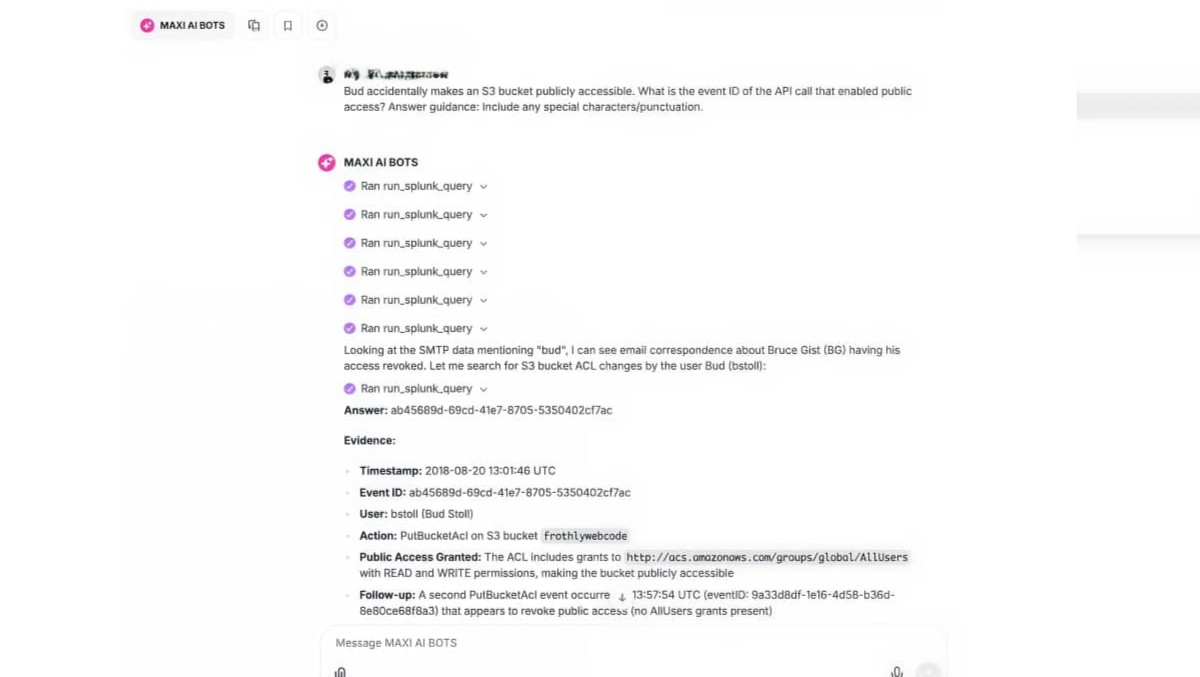

Où le travail rencontre la conversation

ChatOps faisait autrefois référence aux robots Slack qui exécutaient des scripts pré-écrits. Cela aide, mais cela exploite à peine la puissance des agents d’IA, la compréhension du langage naturel et la supervision humaine dans un espace de travail partagé. L’avenir des opérations SOC ne sera pas un meilleur tableau de bord : ce sera une conversation. Un analyste peut commencer la journée en demandant : « Que s’est-il passé pendant la nuit ? et proposez un récit concis qui explique les quelques incidents importants, leur contexte et qui nécessitent une action immédiate.

Si une anomalie d’authentification apparaît, l’analyste demande : « Était-ce légitime ? Le système répond par un raisonnement : adresse IP inhabituelle en Pologne, demande de voyage antérieure, MFA réussie, courte session en lecture seule (probablement légitime mais signalée pour examen). L’analyste peut ensuite explorer en profondeur (« Afficher l’accès à partir de cette adresse IP le mois dernier ») ou pivoter (« D’autres comptes privilégiés présentant des anomalies similaires ? »). Les LLM, le raisonnement enchaîné et l’intégration sécurisée de données en temps réel convergent : le SOC conversationnel passe déjà du concept à la pratique.

La conversation augmente la capacité, mais elle augmente également le risque : les décisions restent sociales et contextuelles. C’est pourquoi le jugement humain devient le cœur d’un nouveau flux de travail dans lequel l’IA fait le gros du travail et les humains assument la responsabilité.

La renaissance de l’être humain sur le circuit

L’IA ne remplacera pas les analystes de sécurité : elle les élèvera. L’automatisation complète semble attrayante, mais la cybersécurité est controversée et étroitement liée au jugement des entreprises ; Les réponses entièrement automatisées deviennent des cibles sur lesquelles les attaquants peuvent enquêter, et de nombreuses décisions (tolérance au risque, arrêt de la production) nécessitent une responsabilité humaine.

La véritable valeur de l’IA est d’éliminer le travail mécanique afin que les analystes appliquent leur expertise là où cela compte. Se démarque dans :

- corrélation : maintenir un contexte large et détecter des modèles subtils dans des millions d’événements ;

- rassembler des preuves : consulter de nombreuses sources en parallèle et résumer les résultats ;

- Reconnaissance de formes : apprendre à quoi ressemble la « normalité » et signaler les écarts.

Le jugement (évaluer l’intention de l’adversaire ou décider d’isoler les systèmes pendant les heures de bureau) reste humain. L’architecture optimale est la collaboration : l’IA prépare des options bien structurées, étudie et développe des hypothèses ; Les analystes portent des jugements, assument leurs responsabilités et dirigent la réponse.

Ce nœud de classification humaine est l’endroit où l’expérience rencontre les preuves, la responsabilité vit, et le SOC reste adaptable et aligné sur les besoins de l’organisation.

Ce que cela signifie pour la prochaine décennie de SecOps

Au cours de la prochaine décennie, les SecOps seront réorganisés autour de conversations plutôt que de tableaux de bord. Attendez-vous à ces changements :

- Les interfaces deviennent des espaces de travail collaboratifs où les analystes et les agents IA enquêtent conjointement en langage naturel.

- La détection est traitée comme du code : continuellement versionnée, révisée, testée et affinée.

- Les rôles se brouillent : les ingénieurs de détection et les analystes SOC co-créent des détections conversationnelles et des cadres de raisonnement.

- Le raisonnement contextuel devient le fossé concurrentiel : la télémétrie sera similaire partout ; La différence réside dans la manière dont vous l’interprétez et agissez en conséquence.

La technologie habilitante (LLM, moteurs de raisonnement, intégration multi-source sécurisée, flux de travail des agents) est en grande partie prête ; Le travail consiste désormais à l’intégration, à la discipline et à l’adoption.

Certaines organisations posent déjà des questions à leurs SOC dans un anglais simple et effectuent des recherches par le biais de conversations. Le reste rattrapera son retard.

Votre SOC parle-t-il toujours par registres ou commence-t-il à penser en contexte ?

L’équipe de sécurité d’UnderDefense est disponible 24h/24 et 7j/7. Triage immédiat, confinement et assistance médico-légale.

Questions fréquemment posées

1. Qu’est-ce qu’un « SOC conversationnel » exactement ?

À SOC conversationnel marque le passage de l’interaction avec les outils de sécurité via des tableaux de bord complexes et des langages de requête spécialisés (langages machine) à l’interaction via langage naturel (discours humain). Au lieu qu’un analyste corrèle manuellement les données de plusieurs silos, ils peuvent poser directement des questions au SOC, telles que « Que s’est-il passé du jour au lendemain ? – et recevez un récit concis et fondé sur des preuves.

2. En quoi un SOC conversationnel est-il différent des manuels de sécurité traditionnels ?

Les manuels traditionnels sont fragile; Ils suivent une logique rigide « si X, alors Y » qui s’effondre souvent lorsqu’un attaquant improvise. En revanche, les SOC conversationnels utilisent boucles de raisonnement. Ces systèmes :

- Ingère dynamiquement les alertes et rassemble le contexte.

- Formuler et tester des hypothèses.

Présenter les résultats aux humains avec une explication de parce que Une certaine conclusion a été atteinte, plutôt que de simplement suivre un scénario pré-écrit.

3. Un SOC conversationnel signifie-t-il que l’IA remplace les analystes en sécurité ?

Non. Le blog met en avant une « Renaissance de l’être humain sur le circuit ». L’IA est conçue pour gérer travail mécanique – comme interroger plusieurs sources, détecter des modèles dans des millions d’événements et collecter des preuves. Cela permet aux analystes humains de se concentrer sur ce qu’ils font le mieux : appliquer jugement de haut niveauévaluer l’intention de l’adversaire et prendre des décisions complexes en matière de risques qui nécessitent des responsabilités.

4. Quelle est la « barrière linguistique » dans les opérations actuelles de cybersécurité ?

Aujourd’hui, les analystes agissent comme des « API humaines » et passent beaucoup de temps à traduire les données entre différents outils (SIEM, EDR, consoles cloud), chacun ayant sa propre syntaxe. Un SOC conversationnel résout ce problème taxe de traduction fournir une couche unifiée où l’IA interprète divers modèles de données et les présente dans un langage simple, permettant à l’équipe de se concentrer sur la menace plutôt que sur l’outil.

5. La technologie est-elle vraiment prête pour un SOC conversationnel aujourd’hui ?

Oui. Les technologies sous-jacentes – Grands modèles de langage (LLM)Des moteurs de raisonnement et une intégration sécurisée des données en temps réel sont désormais disponibles. Alors que le secteur en est encore aux premiers stades d’adoption, certaines organisations avant-gardistes s’éloignent déjà des tableaux de bord statiques et enquêtent sur les incidents via des interfaces conversationnelles.